Nesta secção, vamo-nos debruçar sobre dois problemas, que aliás, e

como veremos, estão relacionados. Assume-se que ![]() é uma matriz

é uma matriz ![]() sobre

sobre

![]() . Essas questões são:

. Essas questões são:

![]() constituída por vectores próprios de

constituída por vectores próprios de ![]() ?

?

![]() invertível para a qual

invertível para a qual

![]() é uma matriz diagonal?

é uma matriz diagonal?

Recordamos a noção de semelhança entre matrizes. As matriz ![]() e

e ![]() dizem-se semelhantes, e denota-se por

dizem-se semelhantes, e denota-se por

![]() , se existir uma

matriz invertível

, se existir uma

matriz invertível ![]() para a qual

para a qual

![]() . Repare que as matrizes

. Repare que as matrizes

![]() são necessariamente quadradas.

são necessariamente quadradas.

É óbvio que se

![]() então

então

![]() ; de facto, se

; de facto, se

![]() então

então

![]() .

.

É óbvio que uma matriz diagonal é diagonalizável, bastando tomar a matriz identidade como matriz diagonalizante.

O resultado seguinte não só nos caracteriza as matrizes diagonalizáveis, mas também, à custa da sua prova, obtemos um algoritmo para encontrar a matriz diagonal e a a respectiva matriz diagonalizante.

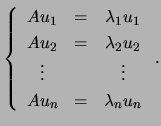

Em primeiro lugar, assumimos que ![]() é diagonalizável; ou seja,

existe uma matriz

é diagonalizável; ou seja,

existe uma matriz

![]() invertível tal que

invertível tal que

![$ U^{-1}AU=D=\left[\begin{array}{ccc} \lambda_1 && 0\ & \ddots &\\

0 && \lambda_n\end{array}\right]$](img1244.png) .

.

Como é óbvio, de

![]() segue que

segue que ![]() . Portanto,

. Portanto,

![$\displaystyle AU=\left[\begin{array}{cccc}u_1 & u_2

&\cdots & u_n\end{array}\ri...

...gin{array}{ccc} \lambda_1 && 0\ & \ddots &\\

0 && \lambda_n\end{array}\right]$](img1248.png) |

|||

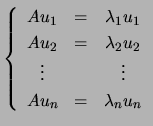

Reciprocamente, suponha que ![]() tem

tem ![]() vectores próprios

linearmente independentes. Sejam eles os vectores

vectores próprios

linearmente independentes. Sejam eles os vectores

![]() ,

associados aos valores próprios (não necessariamente distintos)

,

associados aos valores próprios (não necessariamente distintos)

![]() . Seja

. Seja ![]() a matriz cujas

colunas são os vectores próprios considerados acima. Ou seja,

a matriz cujas

colunas são os vectores próprios considerados acima. Ou seja,

![]() . Ora esta matriz quadrada

. Ora esta matriz quadrada

![]() tem característica igual a

tem característica igual a ![]() , pelo que é invertível. De

, pelo que é invertível. De

![$\displaystyle A\left[\begin{array}{cccc}u_1 & u_2 &\cdots & u_n\end{array}\righ...

...in{array}{ccc} \lambda_1 && 0\ & \ddots &\\

0 && \lambda_n\end{array}\right].$](img1256.png)

![$ \left[\begin{array}{cccc}u_1 & u_2

&\cdots & u_n\end{array}\right]^{-1}$](img1257.png) , obtemos

, obtemos

![$\displaystyle \left[\begin{array}{cccc}u_1 & u_2

&\cdots & u_n\end{array}\right...

...n{array}{ccc} \lambda_1 && 0\ & \ddots &\\

0 && \lambda_n\end{array}\right]

.$](img1258.png)

Realçamos o facto da demonstração do teorema nos apresentar um

algoritmo de diagonalização de uma matriz

![]() com

com ![]() vectores

linearmente independentes. De facto, de

vectores

linearmente independentes. De facto, de

![$ \left[\begin{array}{cccc}u_1 & u_2

&\cdots & u_n\end{array}\right]^{-1} A\left...

...gin{array}{ccc} \lambda_1 && 0\ & \ddots &\\

0 && \lambda_n\end{array}\right]$](img1259.png) obtemos

obtemos

![$\displaystyle A= \left[\begin{array}{cccc}u_1 & u_2

&\cdots & u_n\end{array}\ri...

...right]

\left[\begin{array}{cccc}u_1 & u_2

&\cdots & u_n\end{array}\right]^{-1}.$](img1260.png)

Para a matriz

![$ A=\left[\begin{array}{cc} 1&2\ 2&-2 \end{array}\right]$](img1170.png) , vimos atrás que

, vimos atrás que

![]() . Será

. Será ![]() diagonalizável? Um vector próprio associado ao valor próprio

diagonalizável? Um vector próprio associado ao valor próprio ![]() é um elemento não nulo de

é um elemento não nulo de

![]() . Encontrar um vector próprio associado a

. Encontrar um vector próprio associado a ![]() é equivalente a encontrar uma solução não nula de

é equivalente a encontrar uma solução não nula de

![]() . Fica ao cargo do leitor verificar que

. Fica ao cargo do leitor verificar que

![$ \left[\begin{array}{c} -1\ 2\end{array}\right]$](img1264.png) é vector próprio associado ao valor próprio

é vector próprio associado ao valor próprio ![]() , e fazendo o mesmo raciocínio, que

, e fazendo o mesmo raciocínio, que

![]() é vector próprio associado ao valor próprio 2. Ora estes dois vectores são linearmente independentes, visto

é vector próprio associado ao valor próprio 2. Ora estes dois vectores são linearmente independentes, visto

![$ \mathrm{car}\left[\begin{array}{cc} -1 & 2\ 2 &1\end{array}\right]=2$](img1265.png) . Portanto, a matriz

. Portanto, a matriz ![]() é diagonalizável, sendo a matriz diagonalizante

é diagonalizável, sendo a matriz diagonalizante

![$ U=\left[\begin{array}{cc} -1 & 2\ 2 &1\end{array}\right]$](img1266.png) e a matriz diagonal

e a matriz diagonal

![$ \left[\begin{array}{cc} -3& 0\ 0 &2 \end{array}\right]$](img1267.png) .

.

Octave

![\includegraphics[scale=0.3]{Octave_Sombrero.eps}](img64.png)

A diagonalização, se possível, pode ser obtida de forma imediata como Octave:

> [q,e]=eig (A) q = -0.44721 -0.89443 0.89443 -0.44721 e = -3 0 0 2Aqui, a matriz q, ou seja, o primeiro argumento de saída de eig, indica uma matriz diagonalizante, e o segundo argumento, i.e., e, indica a matriz diagonal cujas entradas diagonais são os valores próprios. Repare, ainda, que a coluna

> q*e*inverse (q) ans = 1.0000 2.0000 2.0000 -2.0000

Considere agora a matriz

![$ B=\left[\begin{array}{cc} 0&0\ 1&0\end{array}\right]$](img1268.png) . Esta matriz é nilpotente, pelo que

. Esta matriz é nilpotente, pelo que

![]() . O espaço próprio associado a 0 é

. O espaço próprio associado a 0 é

![]() . Ora

. Ora

![]() , pelo que

, pelo que

![]() , e portanto a multiplicidade geométrica do valor próprio 0 é 1 (repare que a multiplicidade algébrica do valor próprio 0 é 2). Ou seja, não é possível encontrar 2 vectores próprios linearmente independentes.

, e portanto a multiplicidade geométrica do valor próprio 0 é 1 (repare que a multiplicidade algébrica do valor próprio 0 é 2). Ou seja, não é possível encontrar 2 vectores próprios linearmente independentes.

Octave

![\includegraphics[scale=0.3]{Octave_Sombrero.eps}](img64.png)

Considere a matriz C=[2 1; 0 2]. Sendo triangular superior, os seus valores próprios são os elementos diagonais da matriz. Isto é,

![]() . Repare que a multiplicidade algébrica do valor próprio

. Repare que a multiplicidade algébrica do valor próprio ![]() é 2.

é 2.

> eig (C) ans = 2 2Repare que

![$ \mathrm{car}(2*I_2-C)=\mathrm{car}\left[\begin{array}{cc} 0& 1\ 0&0\end{array}\right]=1$](img1274.png) , pelo que

, pelo que

> rank(2*eye(2)-C)

ans = 1

> [q,e]=eig (C)

q =

1 NaN

0 NaN

e =

2 0

0 2

É, todavia, apresentada uma base do espaço próprio de

Considere agora a matriz

![$ A=\left[\begin{array}{ccc} 1& 2& 1\ 2 &-2& 2\ 0& 0& -3\end{array}\right]$](img1276.png) .

Octave

.

Octave

![\includegraphics[scale=0.3]{Octave_Sombrero.eps}](img64.png)

Para A=[1 2 1;2 -2 2; 0 0 -3] tem-se

![]() , sendo as multiplicidades algébricas de

, sendo as multiplicidades algébricas de ![]() e

e ![]() , respectivamente, 2 e 1.

, respectivamente, 2 e 1.

> eig (A) ans = 2 -3 -3Como

> [q,e]=eig (A) q = 0.89443 -0.44721 NaN 0.44721 0.89443 NaN 0.00000 0.00000 NaN e = 2 0 0 0 -3 0 0 0 -3A primeira coluna de q é um vector próprio associado a 2 e a segunda coluna de q é um vector próprio associado a

O que se pode dizer em relação à independência linear de um vector próprio associado a ![]() e um vector próprio associado a

e um vector próprio associado a ![]() ?

?

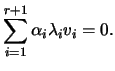

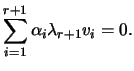

Seja ![]() o menor inteiro para o qual o conjunto

o menor inteiro para o qual o conjunto

![]() é linearmente independente. Ora

é linearmente independente. Ora ![]() já que

já que ![]() (pois é

(pois é ![]() é vector próprio) e

é vector próprio) e ![]() já que o conjunto dos vectores próprios é linearmente dependente. Sendo o conjunto

já que o conjunto dos vectores próprios é linearmente dependente. Sendo o conjunto

![]() linearmente dependente, existem escalares

linearmente dependente, existem escalares

![]() não todos nulos para os quais

não todos nulos para os quais

Alertamos para o facto do recíproco do teorema ser falso. Repare que a matriz identidade ![]() tem

tem ![]() como único valor próprio, e a dimensão de

como único valor próprio, e a dimensão de

![]() ser

ser ![]() , e portanto há

, e portanto há ![]() vectores próprios linearmente independentes associados a

vectores próprios linearmente independentes associados a ![]() .

.

Se uma matriz ![]() tem os seus

tem os seus ![]() valores próprios distintos então, pelo teorema, tem

valores próprios distintos então, pelo teorema, tem ![]() vectores próprios linearmente independentes, o que é equivalente a afirmar que a matriz é diagonalizável.

vectores próprios linearmente independentes, o que é equivalente a afirmar que a matriz é diagonalizável.

Mais uma vez alertamos para o facto do recíproco do corolário ser falso. Isto é, há matrizes diagonalizáveis que têm valores próprios com multiplicidade algébrica superior a 1.

Octave

![\includegraphics[scale=0.3]{Octave_Sombrero.eps}](img64.png)

Considere a matriz A=[0 0 -2; 1 2 1; 1 0 3]. Esta matriz tem dois valores próprios distintos.

> A=[0 0 -2; 1 2 1; 1 0 3]; > eig(A) ans = 2 1 2Repare que o valor próprio 2 tem multiplicidade algébrica igual a 2, enquanto que a multiplicidade algébrica do valor próprio 1 é 1. Pelo teorema anterior, um vector próprio associado a 2 e um vector próprio associado a 1 são linearmente independentes. Repare que a multiplicidade geométrica de

> rank(2*eye(3)-A) ans = 1Como a característica de

> null(2*eye(3)-A) ans = -0.70711 0.00000 0.00000 1.00000 0.70711 0.00000Estes juntamente com um vector próprio associado ao valor próprio 1 formam um conjunto linearmente independente, pois vectores próprios associados a valor próprios distintos são linearmente independentes. Ou seja, há 3 vectores próprios linearmente independentes, donde segue que a matriz

> [v,e]=eig (A) v = 0.00000 -0.81650 0.70656 1.00000 0.40825 0.03950 0.00000 0.40825 -0.70656 e = 2 0 0 0 1 0 0 0 2 > v*e*inverse(v) ans = -0.00000 0.00000 -2.00000 1.00000 2.00000 1.00000 1.00000 0.00000 3.00000